När man driver en webbplats är det viktigt att sökmotorer kan hitta och förstå dess innehåll. Två viktiga filer som hjälper sökmotorer att navigera och indexera din webbplats är sitemap.xml och robots.txt. Men vad är de, och varför är de så viktiga? Låt oss gå igenom detta steg för steg.

Sitemap.xml – En karta över din webbplats

En sitemap.xml är som en karta över din webbplats som hjälper sökmotorer att förstå hur innehållet är strukturerat. Den listar alla viktiga sidor och ger information om hur ofta de uppdateras och hur viktiga de är i förhållande till varandra.

Varför behövs en sitemap.xml?

- Förbättrar indexeringen: Genom att ha en sitemap.xml kan du hjälpa sökmotorer att hitta nya sidor snabbare och se till att allt innehåll som är viktigt indexeras.

- Ökar synligheten: Det är särskilt användbart för större webbplatser eller webbplatser med många undersidor, där det kan vara svårt för sökmotorer att hitta alla sidor på egen hand.

- Meddelar uppdateringar: Om du regelbundet uppdaterar din webbplats kan sitemap.xml informera sökmotorer om när sidor har ändrats, så att sökresultaten förblir aktuella.

Hur fungerar en sitemap.xml?

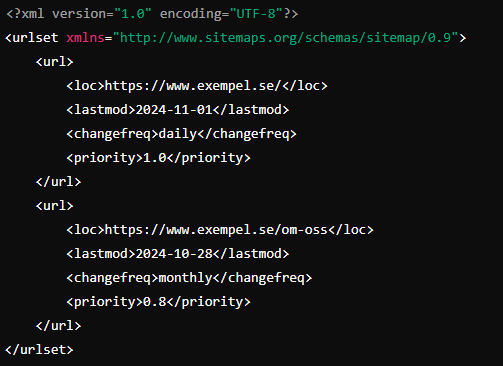

Sitemap.xml är en XML-fil (en typ av textfil) som innehåller webbadresser (URLs) till alla sidor du vill att sökmotorer ska indexera. Här är ett exempel på hur en enkel sitemap.xml kan se ut:

Robots.txt – Din webbplats grindvakt

Robots.txt är en textfil som instruerar sökmotorernas “robotar” om vilka sidor och filer de får (eller inte får) besöka och indexera. Det är som en grindvakt som bestämmer vilken information som ska visas för världen.

Varför behövs en robots.txt?

- Skyddar känsligt innehåll: Vissa sidor på din webbplats är kanske inte relevanta för sökmotorer (t.ex. adminsidor eller utvecklarsidor) och kan exkluderas.

- Styr crawlers: Genom att blockera sökmotorer från att besöka vissa delar kan du spara “crawl budget” – sökmotorernas tid och resurser för att läsa din webbplats – och låta dem fokusera på viktigare sidor.

- Förhindrar duplicerat innehåll: Om du har olika versioner av samma innehåll kan du styra vilka som ska indexeras.

Hur fungerar robots.txt?

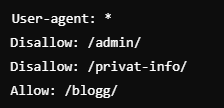

I robots.txt-filen skriver du instruktioner för sökmotorerna. Här är ett exempel:

Vad betyder detta?

- User-agent: * anger att instruktionerna gäller alla sökmotorer.

- Disallow: /admin/ förbjuder sökmotorer från att gå in på admin-sidan.

- Allow: /blogg/ tillåter sökmotorer att indexera blogg-sidan.

Sammanfattning

- Sitemap.xml: En karta över din webbplats som visar sökmotorer var innehållet finns.

- Robots.txt: En dörrvakt som säger vilka delar av din webbplats sökmotorerna får eller inte får besöka.

Att förstå och använda sitemap.xml och robots.txt hjälper din webbplats att synas på bästa sätt i sökmotorerna, samtidigt som du kan kontrollera vad som indexeras.

Är detta svårt att förstå? Kontakta någon av våra SEO-specialister så hjälper vi er!